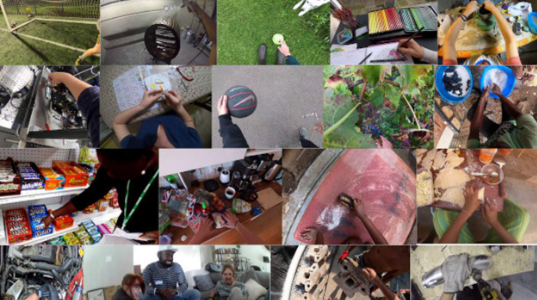

几年后,当 Facebook 发布一副带有摄像头、麦克风和接近传感器的新眼镜时,请记住这篇文章。今天我们来看看 Facebook AI 发布的一些名为“Ego4D”的研究。这项研究与“由 9 个国家/地区的 13 所大学和实验室组成的联盟”合作,共同收集了“2,200 小时的野外第一人称视频,其中包括 700 多名参与者的日常生活。”

研究人员在这项研究中与 Facebook AI 合作的目的是开发“从这个角度理解世界”*的人工智能,以便他们能够“开启沉浸式体验的新时代”。他们正在专门研究增强现实 (AR) 眼镜和虚拟现实 (VR) 耳机如何“在日常生活中变得像智能手机一样有用”。

*这里指的是第一人称视角。他们使用第一人称视角拍摄的视频,而不是通过视频和照片训练 AI 的正常视角:第三人称视角。

研究人员列出了该项目的五个“基准挑战”,有效地展示了他们正在跟踪的内容。需要明确的是:Facebook 没有通过该项目的真实设备跟踪这些数据——现在还没有。这一切都通过 Facebook AI 为该项目获得的第一人称视角视频进行跟踪:

• 情景记忆:什么时候发生的?

• 预测:接下来我可能会做什么?

• 手部和物体操作:我在做什么?

• 视听分类:谁在什么时候说什么?

• 社交互动:谁在与谁互动?

根据 Facebook AI 的说法,他们对这个主题的研究使用的数据集比任何其他数据集都大 20 倍,“就镜头的时长而言”。正是通过Facebook的 Ego4D人工智能项目公告,这些信息才被公开。

标签:

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!